DeepSeek RAM Krizini Bitirecek!

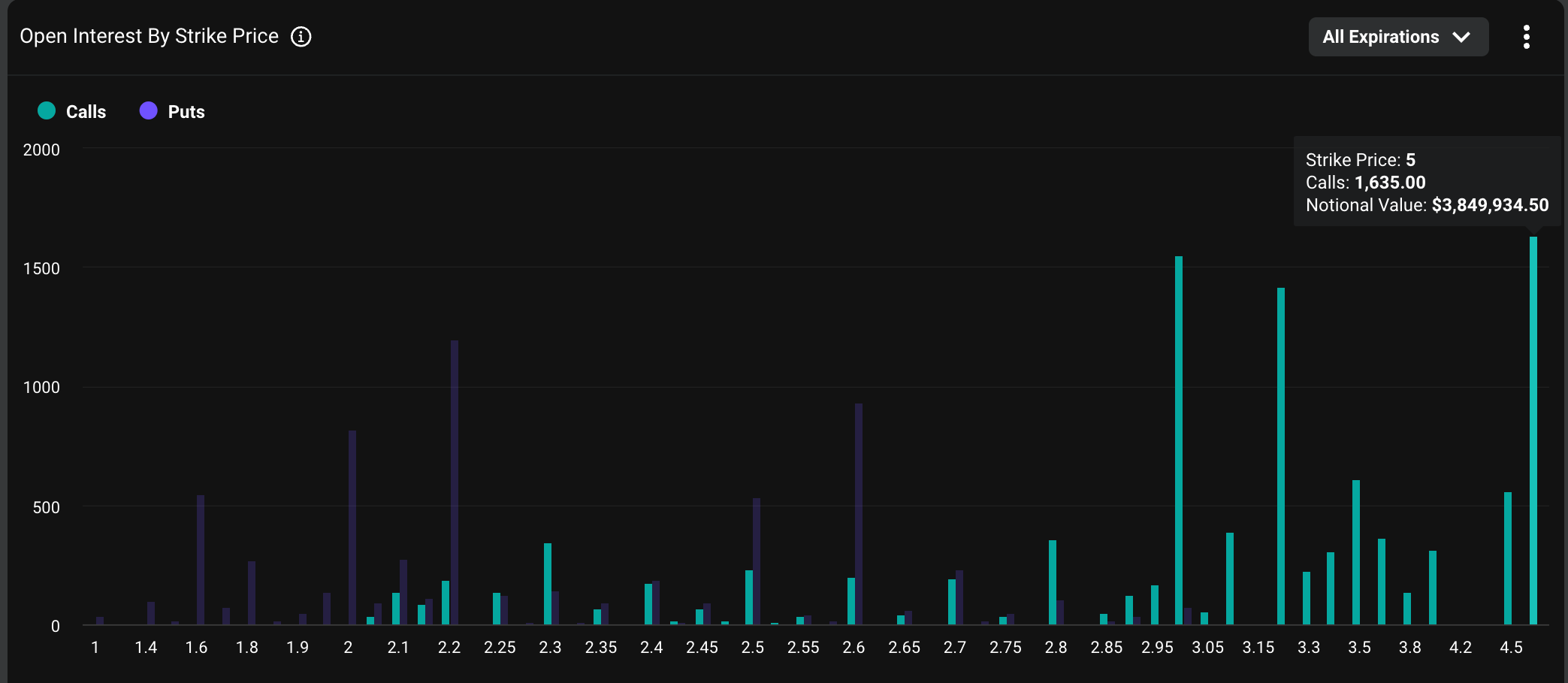

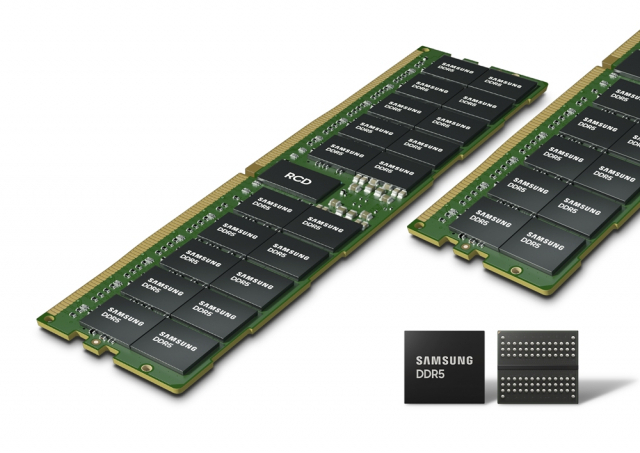

DeepSeek ve Pekin Üniversitesi, yapay zeka dünyasında yaşanan donanım darboğazını aşmak için Engram adında yeni bir eğitim yöntemi geliştirdi. Bu yenilikçi yöntem, bellek depolama alanını hesaplama süreçlerinden ayırarak sistemlerin çok daha verimli çalışmasını sağlıyor. Bilindiği üzere, günümüzdeki büyük dil modelleri bilgiye ulaşmak için çok pahalı olan yüksek bant genişlikli belleklere (HBM) ihtiyaç duyuyor. Bu yoğun talep, DRAM fiyatlarının sadece 10 hafta içinde 5 katına çıkmasının temel nedeni olarak gösteriliyor.

Yapay Zekada Pahalı Donanım Devri Bitiyor mu? DeepSeek Engram’ı Tanıttı

Geliştirilen sistem, modellerin GPU belleğini gereksiz yere doldurmadan ihtiyaç duyduğu bilgileri “arayıp bulmasına” (lookup) olanak tanıyor. Böylece sistemin kapasitesi, basit işlemler yerine daha karmaşık akıl yürütme görevleri için kullanılabiliyor. 27 milyar parametreli bir model üzerinde gerçekleştirilen testler, Engram yönteminin endüstri standartlarında gözle görülür performans artışları sağladığını kanıtladı.

Engram, statik bilgi erişimini anlık işlem yoğunluğundan bağımsız hale getiriyor. Bu yöntem, Phison gibi uygun maliyetli SSD çözümleri ve yeni CXL standartlarıyla birlikte çalışarak toplam bellek kapasitesini artırmayı mümkün kılıyor. Sonuç olarak yapay zeka sistemleri, pahalı bellek birimlerini meşgul etmeden hızlı ve verimli bir şekilde çalışabiliyor.

Araştırmalar, parametre bütçesinin %20 ila %25’lik kısmını Engram modülüne ayırmanın, geleneksel modellere kıyasla daha yüksek performans sağladığını gösteriyor. Bu teknik, özellikle HBM belleklere erişimin zor ve pahalı olduğu bölgelerde donanım üzerindeki baskıyı hafifletebilir. Bu da DRAM fiyatlarındaki ani dalgalanmaların önüne geçilmesine yardımcı olabilir.

Sizce bu tür yazılım tabanlı verimlilik çözümleri, son dönemde artan donanım fiyatlarının düşmesini sağlar mı?